Geração 3.0 #1

O que os líderes estão fazendo com a IA Generativa

Esta é uma newsletter semanal sobre os negócios da indústria de IA e Web3. Para receber a newsletter da Toni em sua caixa de entrada, inscreva-se aqui gratuitamente:

Olá amigos,

Com milhões de postagens sobre "ChatGPT vai matar o Google" nos últimos meses, não é surpresa que, à medida que a temporada de resultados financeiros da grande tecnologia começou, o tema do dia fosse Inteligência Geradora.

Hoje, vou discutir o que as grandes empresas de tecnologia - Google, Facebook, Microsoft, Amazon e Apple - disseram sobre seus planos para Inteligência Geradora em sua última chamada de resultados na semana passada.

I. Microsoft

A Microsoft tem sido indiscutivelmente a líder na última onda de LLMs e IA generativa, investindo mais de US$ 10 bilhões na OpenAI e fechando uma parceria exclusiva com eles para ser seu provedor de nuvem.

Mas vamos discutir o que eles estão fazendo de maneira mais holística.

A era da IA está sobre nós e a Microsoft está alimentando isso. - Satya Nadella

A. AI para desenvolvedores

A Microsoft tornou o serviço Azure OpenAI amplamente disponível em janeiro. Hoje, o Azure parece estar melhor posicionado para se beneficontar dessa onda de modelos de base.

À medida que os clientes escolhem seus provedores de nuvem e investem em novas cargas de trabalho, estamos bem posicionados para capturar essa oportunidade como líderes em AI. Temos a infraestrutura de supercomputação de IA mais poderosa na nuvem. Está sendo usado por clientes e parceiros como OpenAI para treinar modelos e serviços de ponta, incluindo ChatGPT. Na semana passada, tornamos o nosso serviço Azure OpenAI amplamente disponível e já mais de 200 clientes, desde KPMG até Al Jazeera, estão usando-o.

O Azure também será o provedor de nuvem exclusivo da OpenAI.

Em breve, adicionaremos suporte ao ChatGPT, permitindo que os clientes o usem em suas próprias aplicações pela primeira vez. E ontem, anunciamos a conclusão da próxima fase de nosso acordo com OpenAI. Estamos satisfeitos por ser seu provedor de nuvem exclusivo ... Toda essa inovação está impulsionando o crescimento em todos os nossos serviços de AI do Azure.

Talvez o maior benefício da Microsoft seja preparar sua infraestrutura antecipadamente (embora o Google tenha algo a dizer sobre isso) para esse mundo que está por vir:

Isso, em algum sentido, está sob o radar, se você quiser, nos últimos três anos e meio, quatro anos, estamos trabalhando muito, muito duro para construir tanto os supercomputadores de treinamento quanto agora, é claro, a infraestrutura de inferência, porque uma vez que você usa AI dentro de suas aplicações, ela passa a ser pesada para inferência.

B. AI para usuários finais

A Microsoft deixou claro que quer trazer as capacidades de AI baseadas em LLMs para todos os seus aplicativos.

O GitHub Copilot é, na verdade, você diria, o produto baseado em LLM de maior escala disponível no mercado atualmente. E assim, esperamos que incorporemos IA em todas as camadas da pilha, seja em produtividade, seja em nossos serviços ao consumidor.

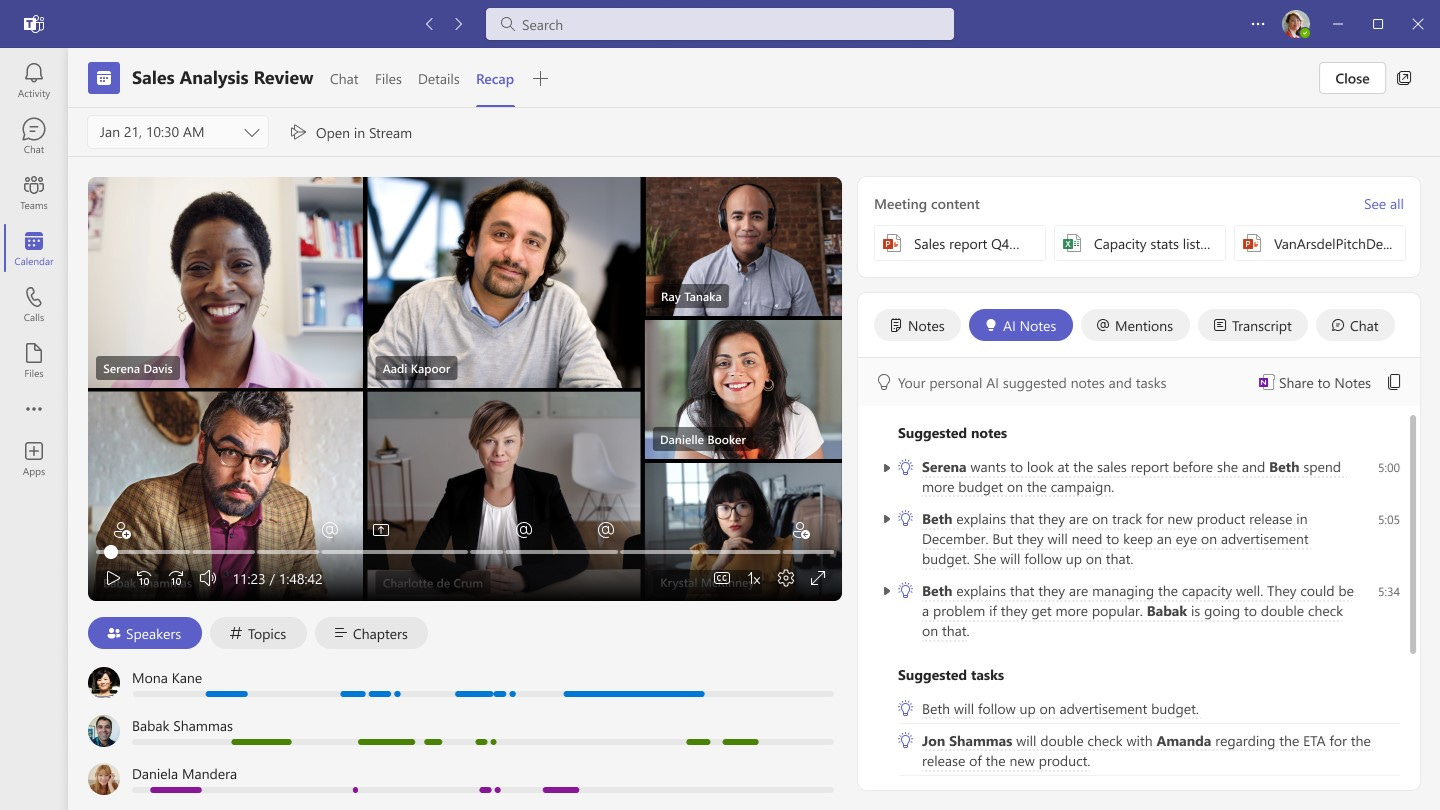

Teams ganham AI

Já começamos a ver algumas prévias disso, com eles recentemente apresentando as características de AI do Teams Premium, incluindo:

Notas e itens de ação gerados por AI

Capítulos gerados por AI

Marcadores gerados por AI

AI no Microsoft 365 também está chegando

Embora não tenha sido mencionado especificamente, Satya também confirmou que os recursos de IA chegariam ao Excel, Powerpoint, Outlook, Word, etc. Houve rumores em janeiro de que a Microsoft estava experimentando isso, e as dicas na chamada de ganhos mais ou menos confirmam isto

O Microsoft 365 está rapidamente evoluindo para uma plataforma AI-first que permite que cada indivíduo amplifique sua criatividade e produtividade tanto com nossos aplicativos estabelecidos, como com novos aplicativos como Designer, Stream e Loop.

C. Parceria com a OpenAI

A Microsoft se associou pela primeira vez com a OpenAI há cerca de 3 anos, investindo 1B de dólares (e potencialmente até 3B de dólares com mais investimentos em 2021). Nos últimos meses, eles aprofundaram essa parceria, com outro investimento de 10B de dólares em uma estrutura onde eles recebem 49% dos lucros de volta até serem reembolsados (após outros investidores iniciais serem reembolsados primeiro).

Mas isso não é apenas um investimento financeiro, é claro.

A OpenAI usa o Azure exclusivamente para todo o seu treinamento e inferência, incluindo seus produtos lançados (o ChatGPT também é executado no Azure)

O Azure disponibiliza o OpenAI para clientes corporativos por meio do serviço Azure OpenAI, capturando a computação em nuvem dessas cargas de trabalho.

A Microsoft integra os modelos da OpenAI em seus aplicativos e produtos (o que, para ser justo, qualquer empresa pode fazer…)

O Satya resume bem:

Então, nós olhamos para ambos, há uma parte de investimento e uma parceria comercial. Mas fundamentalmente, isso será algo que irá impulsionar, acho eu, a inovação e a diferenciação competitiva em cada uma das soluções da Microsoft, liderando em IA.

II. Alphabet

A Google vem se considerando uma empresa de AI há cerca de 6 anos, então não é surpresa que ela continue sendo uma parte importante da conversa. Mas com muitas pessoas sugerindo que produtos como o ChatGPT poderiam ser o que finalmente ameaçaria a Google, esta chamada teve muitas discussões.

AI é a tecnologia mais profunda com a qual estamos trabalhando hoje. Nossos talentosos pesquisadores, infraestrutura e tecnologia nos colocam extremamente bem posicionados à medida que a AI alcança um ponto de inflexão. - Sundar Pichai

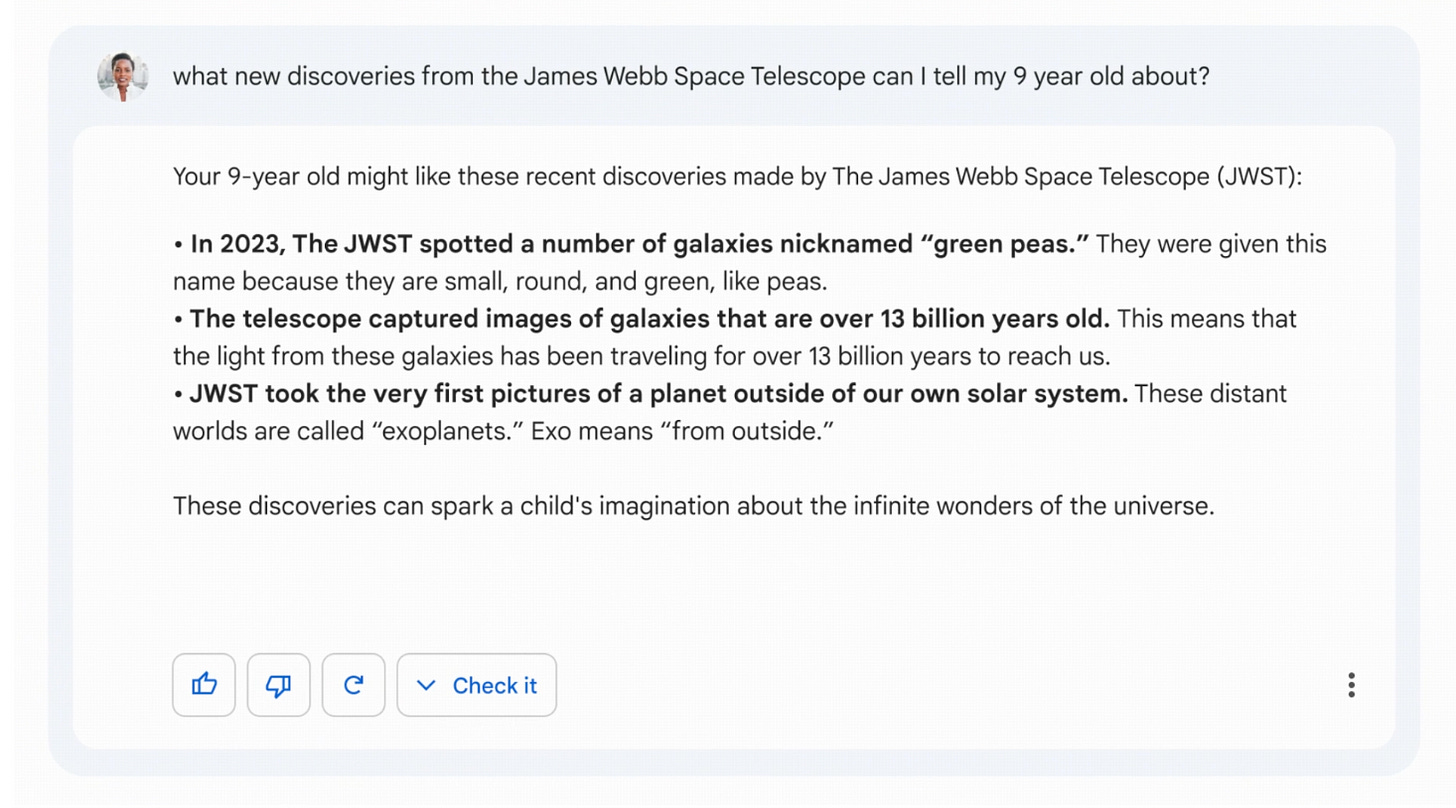

A. AI para usuários finais

Uma alternativa ao ChatGPT chamada Bard chegou

A Google já falou sobre seu modelo PaLM, o Pathways Language Model treinado com 540B de parâmetros, e LaMDA (Language Model for Dialogue Applications) no contexto de projetos de pesquisa.

Em sua teleconferência de resultados, eles deixaram claro que disponibilizarão esses modelos para que as pessoas possam começar a se envolver com eles, começando pelo LaMDA.

Publicamos extensivamente sobre LaMDA e PaLM, o modelo mais sofisticado e maior da indústria, além de trabalho extenso na DeepMind. Nas próximas semanas e meses, disponibilizaremos esses modelos de linguagem, começando com LaMDA, para que as pessoas possam se envolver diretamente com eles. Isso nos ajudará a continuar a obter feedback, testar e melhorá-los com segurança. Esses modelos são particularmente incríveis para compor, construir e resumir.

Sundar até sugeriu uma área em que a versão do Google pode ser melhor do que o ChatGPT hoje: ser atualizado e mais factual.

Eles se tornarão ainda mais úteis para as pessoas, pois fornecem informações atualizadas e mais factuais.

Semana passada, eles anunciaram o sistema, detalhando Bard, sua alternativa ao ChatGPT, e novamente destacaram que “combinaremos feedback externo com nossos próprios testes internos para garantir que as respostas de Bard atendam a um alto padrão de qualidade, segurança e fundamentação em informações do mundo real.

Para surpresa de zero pessoas dentro do próprio Google, o anuncio foi um fiasco.

Melhoria no Google Search

Sundar também deu a entender que seus modelos de linguagem mais poderosos chegarão à pesquisa em alguns formatos experimentais.

Modelos de linguagem como BERT e MUM têm melhorado os resultados de pesquisa há quatro anos, possibilitando melhorias significativas nas classificações e pesquisas multimodais como o Google Lens. Em breve, as pessoas poderão interagir diretamente com nossos modelos de linguagem mais novos e poderosos como companheiros de pesquisa de formas experimentais e inovadoras. Fique ligado.

IA em Docs, Mail e Workspace

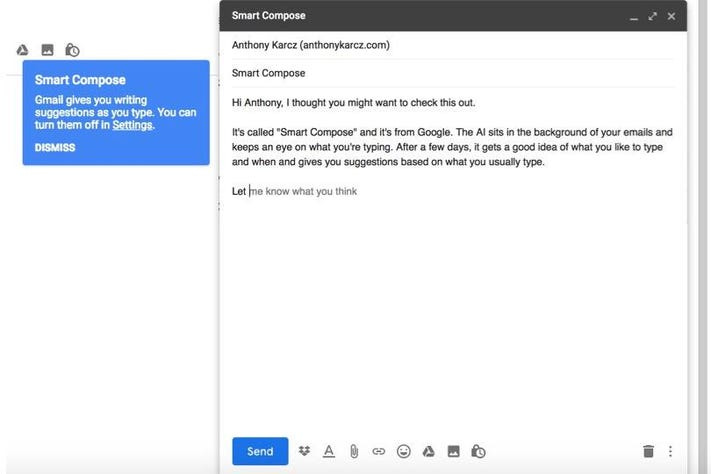

Google também confirmou que levará LLMs para o Gmail e Docs e outras superfícies no Workplace. Recursos como o Smart Compose e outros estão chegando em breve. Me pergunto o que isso fará com muitas das startups de AI geradas por texto/email.

Os usuários do Workspace se beneficiam de recursos baseados em IA, como Smart Canvas para colaboração e Smart Compose para criação; e estamos trabalhando para trazer grandes modelos de linguagem para o Gmail e o Docs. Também disponibilizaremos outros recursos generativos úteis, desde a codificação até o design e muito mais.

B. AI para Desenvolvedores

Para não ficar atrás nas guerras de nuvem no contexto de LLMs, o Google também estará disponibilizando seus próprios modelos de linguagem e AI multimodal para desenvolvedores e fortalecendo sua plataforma de AI na nuvem.

Forneceremos novos ferramentas e APIs para desenvolvedores, criadores e parceiros. Isso os permitirá inovar e construir suas próprias aplicações e descobrir novas possibilidades com AI, além de nossos modelos de linguagem, multimodais e outros de AI.

O Google Cloud está tornando nossa liderança tecnológica em AI disponível para os clientes via nossa plataforma Cloud AI, incluindo infraestrutura e ferramentas para desenvolvedores e cientistas de dados, como o Vertex AI.

C. AI para Anunciantes

Os algoritmos de correspondência do Google obviamente já usam muita IA. Por exemplo, LLMs são usados para corresponder anunciantes a consultas de usuários, o que pode melhorar o desempenho em até 35% em determinadas campanhas.

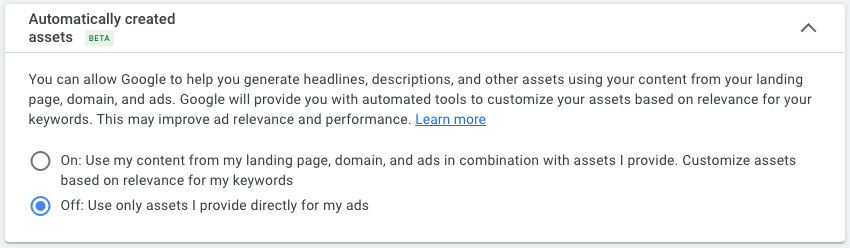

Mas o Google também começará a usar GenAI mais intensivamente. Para começar, o Google estará incorporando-o em seus produtos criativos de anúncios, como usar AI para gerar títulos, descrições, etc.

Estamos ansiosos para começar a testar nossa versão beta de recursos criados automaticamente, que usa IA para gerar títulos e descrições para criativos de pesquisa de forma integrada assim que os anunciantes aceitam. – Philipp Schindler, CBO do Google

Se você ainda não recebe a newsletter do Toni em sua caixa de entrada de e-mail, junte-se aos mais de 50 assinantes aqui:

III. Meta

Em meio a toda a conversa sobre o Metaverso, é fácil esquecer que o Meta também tem investido muito em IA, embora principalmente no lado das recomendações até o momento, para poder fazer recomendações em suas aplicações e produtos publicitários. Mas eles pretendem também impulsionar a IA Generativa, como Zuckerberg deixou claro na chamada de ganhos.

A IA Generativa é uma nova área extremamente empolgante com tantas aplicações diferentes, e um de meus objetivos para a Meta é construir sobre nossa pesquisa para se tornar líder em IA Generativa, além de nosso trabalho líder em IA de recomendação. - Mark Zuckerberg

Na verdade, Zuckerberg até destacou que os dois maiores temas para 2023 na Meta são: 1) eficiência e 2) trabalho generativo de IA.

A. IA para usuários finais

Zuck sugeriu que a Meta está trabalhando na integração de LLMs e modelos de difusão em cada uma de suas aplicações, para gerar imagens, vídeos, avatares e ativos 3D. Pode-se imaginar coisas como edição de imagem/vídeo através de prompts e geração de imagem/vídeo usando os avatares (ou rostos) das pessoas através de prompts uma vez que a tecnologia chegue lá. No entanto, ele foi muito bem informado sobre a implementação exata nos aplicativos.

Temos um monte de diferentes fluxos de trabalho em quase todos os nossos produtos para usar as novas tecnologias, especialmente os modelos de linguagem grande e modelos de difusão para gerar imagens e vídeos e avatares e ativos 3D e todos os tipos de coisas diferentes em todos os diferentes fluxos de trabalho em que estamos trabalhando.

Meta também destacou os desafios de escalonamento e sua abordagem experimental/iterativa a estes. Sobre sua abordagem, disse Zuckerberg:

Portanto, acho que você nos verá lançar uma série de coisas diferentes este ano, e falaremos sobre elas, e compartilharemos atualizações sobre como elas estão se saindo. Eu espero que o espaço se mova rapidamente. Creio que aprenderemos muito sobre o que funciona e o que não funciona.

Ao escalar, Zuckerberg observou que reduzir o custo da inferência é importante para levar isto aos bilhões de usuários em suas aplicações.

Muito do material é caro, certo, para gerar uma imagem ou um vídeo ou uma interação por bate-papo. Estas coisas de que estamos falando, como centavos ou fração de um centavo. Portanto, um dos grandes desafios interessantes aqui também será como escalar isto e tornar este trabalho mais eficiente para que possamos levá-lo a uma base de usuários muito maior. Mas eu acho que uma vez que fizermos isso, haverá uma série de casos de uso muito interessantes.

B. AI para eficiência interna

De passagem, Zuckerberg mencionou que Meta estará "implantando ferramentas de IA para ajudar nossos engenheiros a serem mais produtivos".

Li que, como eles estão implantando potencialmente um produto tipo Copilot que é potencialmente aperfeiçoado ou treinado em sua base de código internamente para aumentar a eficiência do desenvolvimento, bem como adicionando IA à revisão de código e outras ferramentas.

C. AI para anunciantes

Grande parte do negócio principal usa muito a IA, mas e o GenAI? Embora Meta não fosse específico, eles indicaram que estão investindo pesadamente em IA para construir ferramentas que facilitem aos anunciantes a criação e entrega de anúncios relevantes e envolventes. Eu entendi isso como uma dica de que eles estão trabalhando para trazer algumas das capacidades generativas de IA de imagens e vídeo para a criação de ativos para os anunciantes.

Estamos investindo fortemente em IA para desenvolver e implantar tecnologias de melhoria da privacidade e continuar a construir novas ferramentas que tornarão mais fácil para os anunciantes criar e veicular anúncios mais relevantes e envolventes.

IV. Amazon

Não houve nenhuma menção à IA na recente chamada de rendimentos da Amazon. Dada a ênfase que Azure e GCP estão colocando nas cargas de trabalho da IA, estou surpreso que Andy não tenha mencionado nada especificamente nem tenha sido perguntado sobre os planos lá.

O único destaque no relatório de ganhos na frente do cliente foi que a Stability AI escolheu a AWS como seu fornecedor preferido de nuvens.

A Stability AI escolheu a AWS como seu fornecedor preferido de nuvens para construir e treinar modelos de inteligência artificial (IA) para o melhor desempenho com o menor custo.

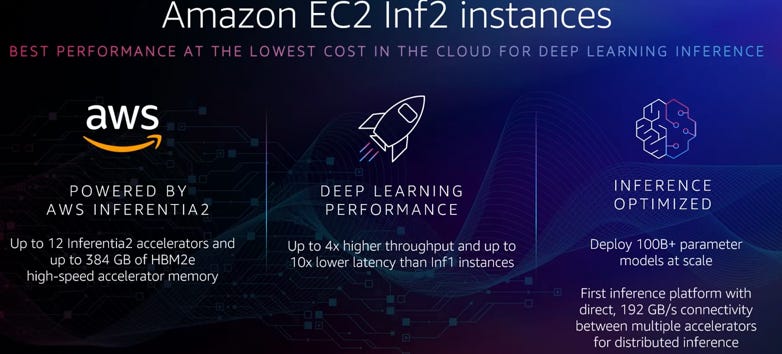

Da mesma forma, na frente do produto, a única coisa chamada para fora foram as instâncias Inf2 para baixa latência e inferência ML de baixo custo.

Anunciadas ... Instâncias Inf2, alimentadas por chips AWS Inferentia2, que fornecem a menor latência ao menor custo para inferência ML no EC2 da Amazon.

V. Apple

A Apple foi bastante criticada por seus planos exatos, mas notou que a IA é seu maior foco quando pressionada e que afetaria todos os produtos em todos os serviços que eles têm. Eu não esperaria grandes mudanças em breve, porém, a julgar pela necessidade de que eles fossem questionados sobre a IA para mencioná-la.

Sim. Ela [IA] é um dos nossos principais focos. É incrível em termos de como ela pode enriquecer a vida dos clientes. E você não pode ir além de algumas das coisas que anunciamos no outono com a detecção de colisões e quedas ou com o ECG.

Estas coisas salvaram literalmente a vida das pessoas. E assim vemos um enorme potencial neste espaço para afetar virtualmente tudo o que fazemos. É obviamente uma tecnologia horizontal, não uma vertical. E assim afetará cada produto em cada serviço que tivermos. - Tim Cook

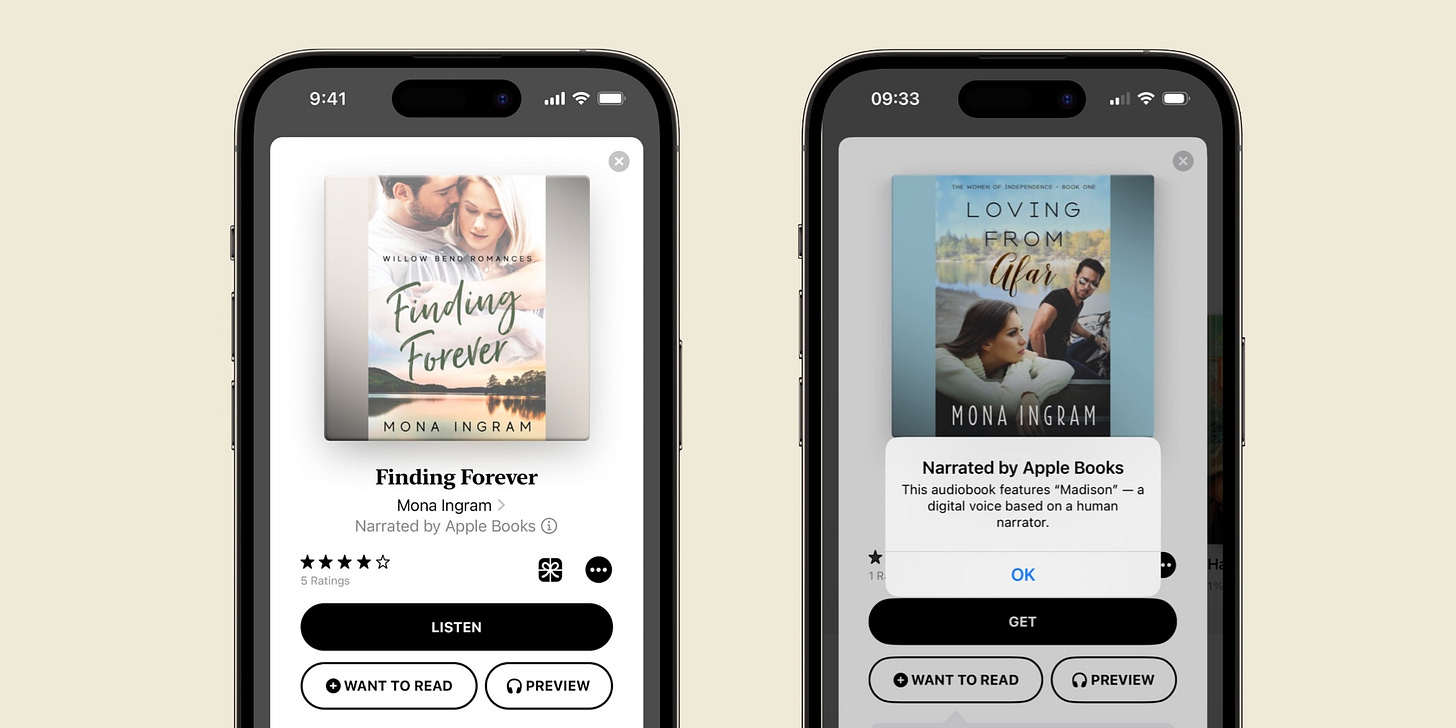

Uma característica que eles lançaram recentemente foram os audiolivros com AI-narrated, que poderiam indicar alguns dos tipos de formas que eles pretendem integrar a IA em aplicações.

Obrigado por ler! Se você gostou deste post, dê-lhe um coração acima para ajudar os outros a encontrá-lo ou compartilhá-lo com seus amigos.

Se você tiver algum comentário ou pensamento, sinta-se à vontade para tweetar para mim.

Se você não é um assinante, você pode assinar gratuitamente abaixo. Escrevo sobre coisas relacionadas à tecnologia e negócios uma vez por semana às segundas-feiras.